پایگاه خبری راه پرداخت دارای مجوز به شماره ۷۴۵۷۲ از وزارت فرهنگ و ارشاد اسلامی و بخشی از «شبکه عصر تراکنش» است. راه پرداخت فعالیت خود را از دوم اردیبهشتماه ۱۳۹۰ شروع کرده و اکنون پرمخاطبترین رسانه ایران در زمینه فناوریهای مالی، بانکداری و پرداخت و استارتآپهای فینتک است.

آیا تا ابد هوش مصنوعی به مبارزه با فسادهای نظاممند مالی کمک خواهد کرد؟

بررسیهای سازمان Transparency International نشان میدهد میزان بروز «فساد» در کشورها با سطح دسترسی به «کلاندادهها»، نسبت عکس دارد، یعنی در کشورهایی که دسترسی آزاد به دادههای عظیم وجود ندارد، میزان فساد بیشتر است، هوش مصنوعی در دسترسی به کلاندادهها خدمات بسیاری را برای بشر انجام داده است.

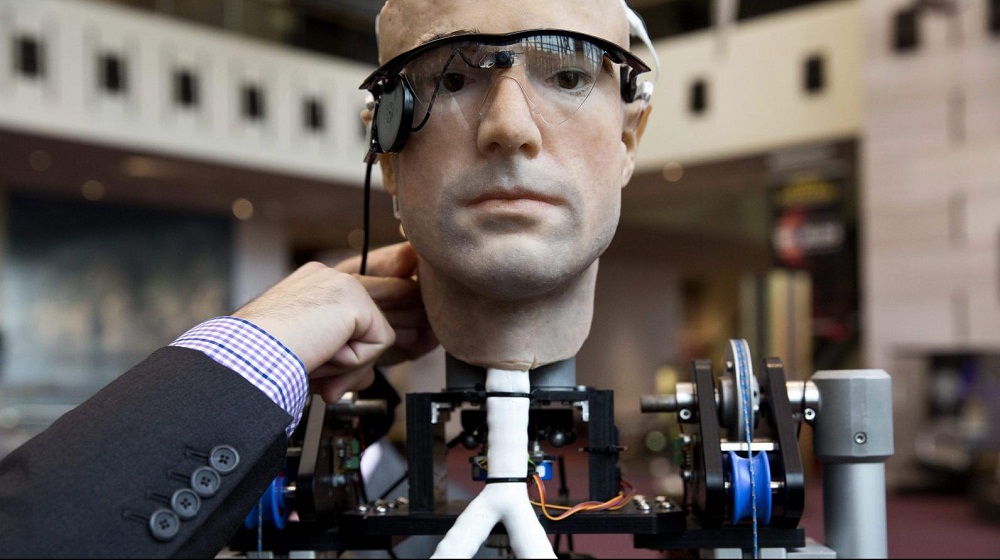

ماهنامه عصر تراکنش شماره ۳۰ / «استیون هاوکینگ» (Stephen Hawking) از جمله افرادی است که پیشرفت افسارگسیخته فناوریهای حوزه هوش مصنوعی را به نفع بشر نمیداند. او معتقد است موفقیت در ساخت هوش مصنوعی را باید بزرگترین و در عین حال «بدترین» رخداد تاریخ تمدن بشر به حساب آورد.

«بزرگترین» از این جهت که در کوتاهمدت، میتواند بسیار کمککننده و مفید باشد؛ البته این موضوع هم تا حدود زیادی بسته به اینکه چه کسی کنترل آن ماشین هوشمند را در دست میگیرد، متغیر است. «بدترین»، از این جهت که اگر این ماشین، در بلندمدت «تکامل» یابد و بتواند بدون کمک بشر، خود را بهبود بخشد و پیشرفت کند، به ماشین «ابرهوشمندی» تبدیل میشود که غیر قابل پیشبینی و کنترل است و احتمالا اگر اهدافش با اهداف اجدادش (انسانها) همراستا نباشد، درصدد نابودی آنها برخواهد آمد.

به قول «ماروین مینسکی»؛ «ما شانس آوردهایم؛ اگر آنها بخواهند ما را در اطراف منزل همچون حیوانات اهلی نگه دارند.» موضوع به قدری جدی و نگرانکننده است که هاوکینگ، در سال ۲۰۱۶ «مرکز Leverhulme» را در کمبریج برای انجام تحقیقات بیشتر و دقیقتر درباره آینده هوش مصنوعی تاسیس میکند. «ایلان ماسک»، «بیل گیتس» و بسیاری از بزرگان حوزه فناوری اطلاعات و کامپیوتر نیز با «هاوکینگ» همعقیدهاند.

زمان زیادی از تعطیلشدن پروژه باتهای هوشمند فیسبوک، «باب» و «آلیس» نمیگذرد؛ باتهایی که با ایجاد تغییراتی در زبان پیشفرضشان (انگلیسی) به زبان جدیدی میرسند و با این زبان جدید با یکدیگر ارتباط برقرار میکنند؛ زبانی که برای طراحانشان غیرقابل درک است. هدف اصلی فیسبوک، صرفا طراحی باتهای هوشمندی بود که بتوانند با مردم صحبت کنند، اما نتیجه شگفتانگیز بود و باتها با زبانی جدید با یکدیگر ارتباط برقرار کردند؛ نکته این است که باتها برای حصول بهترین نتیجه، هیچ قیدوبند و محدودیتی برای خود قائل نبودند.

«ماکس تگمارک»، رئیس موسسه «آینده حیات» معتقد است اگر با مدیریت صحیح، بتوانیم «هوش انسان» را با «هوش مصنوعی» تقویت کنیم، چنان نتایج درخشانی حاصل خواهد شد که قبل از این فکرش را هم نمیکردیم. به نظر میرسد نکته کلیدی، «مدیریت صحیح» است، اما سوال اینجاست که آیا «مدیریت» صحیح این چالش امکانپذیر است؟ آیا میتوان با اطمینان کامل گفت «ماشینهای ابرهوشمند» در آینده، قابل کنترل و مدیریت خواهند بود؟

سه قانون مهم

بشر از گذشتههای دور، رویای طراحی و ساخت موجوداتی هوشمند شبیه به خود را در سر میپرورانیده است، اما بخش عمده فعالیتهای حوزه رباتیک و ماشینهای هوشمند از قرن بیستم آغاز شده است: کلمه «ربات» را اولینبار Karel Čapek در سال ۱۹۲۰ در یکی از نمایشنامههایش به کار برد. در این نمایشنامه رباتها موجوداتی بودند که از اربابان خود اطاعت میکردند.

در سال ۱۹۵۰، «آیزاک آسیموف» نویسنده معروف داستانهای علمی ـ تخیلی در کتاب «من، ربات هستم»، تصویری زیبا از همزیستی رباتهای هوشمند و انسانها در آینده ارائه میدهد و پیشبینی میکند زندگی انسانها و ماشینهای هوشمند تا حد زیادی با هم گره خواهد خورد. او در این کتاب سه قانون مهم در خصوص رباتها وضع میکند که همه رباتها باید از آن پیروی کنند:

قانون اول: ربات هرگز نباید به آدمها صدمه بزند یا بگذارد به آنها صدمهای برسد.

قانون دوم: ربات باید از هر دستوری که آدمها به او میدهند، اطاعت کند، مگر دستوری که با قانون اول مغایرت داشته باشد.

قانون سوم: ربات باید از خودش بهخوبی محافظت کند؛ به شرط آنکه با قانونهای اول و دوم مغایرت نداشته باشد.

پیشگامی به نام تورینگ

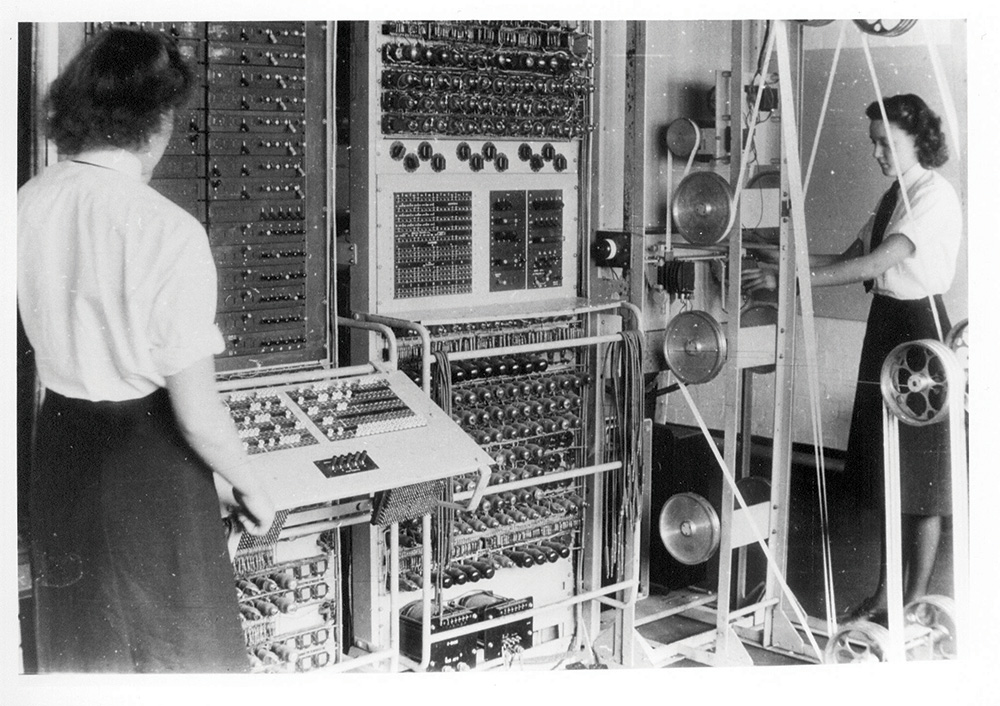

همهچیز از یک سوال بهظاهر ساده شروع میشود: «آیا ماشینها هم میتوانند فکر کنند»؟ سوالی که سالها ذهن ریاضیدان بریتانیایی، «آلن ماتیسون تورینگ» را به خود مشغول کرده بود.

ریاضیدانی (احتمالا) مبتلا به «سندروم آسپرگر» که در جنگ جهانی دوم، توانست با «ماشین تورینگ (=کامپیوتر)» که خودش آن را طراحی کرده بود، پیامهایی را که توسط «ماشین انیگما» (پیچیدهترین ماشین رمزگذاری آلمانها)، رمزگذاری میشدند، رمزگشایی کند و با دسترسی به اطلاعات و پیامهای محرمانه، باعث ناکامماندن بسیاری از حملات کلیدی آنها شود. مورخان تخمین میزنند با این کار، جنگ بیش از دو سال کوتاهتر و جان بیش از ۱۴ میلیون نفر، نجات داده شده است.

فعالیتها و نظریات تورینگ، بهعنوان پایههای اصلی حوزههای «علوم کامپیوتر» و «هوش مصنوعی»، الهامبخش محققان دیگر این حوزه بوده و هست. تورینگ، در سال ۱۹۵۴ میلادی و در ۴۱سالگی دست به خودکشی زد و به حیات خود پایان داد.

فعالیتهای جدی علمی و عملی در حوزه ماشینهای هوشمند و هوش مصنوعی، با فعالیتهای تورینگ آغاز شدند و پس از او همچنان ادامه مییابند. دو سال بعد از مرگ تورینگ یعنی در سال ۱۹۵۶، «جان مک کارتی» از دانشگاه دارموث، «ماروین مینسکی» از دانشگاه هاروارد، «ناتانیل روچستر» از IBM و «کلاود شنون»، واژه «هوش مصنوعی» را برای اولینبار و در مفهوم امروزی آن، در کنفرانس دارموث به کار بردند.

طی این سالها، تعاریف متعددی برای «هوش مصنوعی» مطرح شده که البته با توجه به اینکه تعریف دقیقی از «هوش» نداریم، بالطبع نمیتوانیم تعریف دقیقی از «هوش مصنوعی» ارائه دهیم، اما در حالت کلی، هوش مصنوعی، مطالعه و جستوجوی راههای وادار کردن «ماشین ـ رایانه»، به انجام کارها و حل مشکلاتی است که در حال حاضر، انسانها آن را بهتر انجام میدهند.

بهطور کلی میتوانیم هوش مصنوعی را در قالب دو رویکرد عمده بررسی کنیم؛ «هوش مصنوعی ضعیف (Weak)» و «هوش مصنوعی قوی (Strong)». در رویکرد «هوش مصنوعی ضعیف»، ماشین ـ رایانه، صرفا ویژگیهای «یک جنبه خاص» از هوش انسان را نشان میدهد (مثلا، تشخیص چهره که امروزه روی گوشیهای تلفن همراه وجود دارد و…)، اما در رویکرد «هوش مصنوعی قوی» هدف، طراحی و ساخت ماشینی است که تمامی قابلیتهای شناختی انسان را یکجا داشته باشد؛ ویژگیهایی مثل آگاهی، اراده، یادگیری، فهم زبان، همدردی، تصمیمگیری و… .

سوال مهم؛ ماشین میفهمد؟

سوال اصلی این است که آیا ماشین، واقعا «میفهمد» و «فکر میکند»؟ تورینگ معتقد است اگر انسان نتواند تشخیص دهد پاسخهایی که در جواب به سوالهایش دریافت میکند، بهوسیله یک انسان دیگر نوشته شدهاند، یا یک ماشین ـ در حالی که پاسخها بهوسیله یک ماشین ارائه شده باشند ـ میتوان گفت آن ماشین «فکر میکند». به این آزمون، «تست تورینگ» میگوییم.

مک کارتی، پا را کمی فراتر میگذارد. او میگوید: «حتی درباره ماشینهایی که به اندازه ترموستاتها سادهاند، میتوان گفت که دارای باورند.» ترموستات مدنظر مک کارتی سه باور دارد؛ اینجا خیلی گرم است، اینجا خیلی سرد است، اینجا خوب است، اما عدهای با این نوع نگرش مخالفاند؛ آنها معتقدند ماشینها صرفا دارای نحو (Syntax) و فاقد معناشناسی (Semantics) هستند.

«جان سرل» یکی از این افراد است. استدلالی که او برای این موضوع مطرح میکند «آزمایش فکری»ای است که با نام «استدلال اتاق چینی» شهرت یافته است؛ فرض کنید در یک اتاق دربسته حضور دارید و قرار است سوالهایی را که به زبان چینی مطرح شدهاند، به زبان چینی پاسخ دهید، شما هیچ آشنایی با زبان چینی ندارید و کلمات برای شما صرفا خطوط کج و معوجی روی کاغذ هستند.

شما کتابچه راهنمایی در اختیار دارید که کلمات چینی و قواعد کلی را به «زبان مادریتان» برایتان توضیح داده است. شما با کمک این کتابچه راهنما کلمات را کنار هم میچینید و به سوالات پاسخ صحیح میدهید. ناظر بیرونی که پاسخهای شما را بررسی میکند، احساس میکند زبان چینی زبان مادری شماست، اما نکته اینجاست که پاسخهای صحیح شما، به معنای این نیست که زبان چینی بلدید. «کتابچه راهنما» در اصل همان «برنامه»ای است که برنامهنویسان به کامپیوتر میدهند و کامپیوتر، صرفا بر اساس آن عمل میکند، اما معنا را نمیفهمد.

نسبت کلاندادهها و فساد

فارغ از بحثهای فلسفی و تخصصی، چه بخواهیم چه نخواهیم، امروز در دنیایی زندگی میکنیم که «مجبوریم» هر روز با ماشینهایی هوشمند تعامل داشته باشیم. به عبارت بهتر هوش مصنوعی در متن زندگی ما قرار دارد و به نظر میرسد بهترین راه، شناخت کامل پتانسیلهای نهفته آن (از پزشکی تا اقتصاد، از نویسندگی تا رانندگی و…) و تلاش برای مدیریت صحیح شرایط است.

یکی از پتانسیلهای هوش مصنوعی، کمک به انسانها در راه مقابله با فساد و جرائم سازمانیافته است. «فساد»، استفاده نادرست و غیراخلاقی از قدرت، برای رسیدن به منافع شخصی است. گزارش سال ۲۰۱۹ سازمان «شفافیت بینالملل» (Transparency International) نشان میدهد بسیاری از کشورها نتوانستهاند اقدامی درست و بنیادین برای مقابله با فساد انجام دهند. موضوعی که بهتازگی مورد توجه کشورهای صنعتی و در حال توسعه قرار گرفته، استفاده از هوش مصنوعی، دادههای باز و کلانداده برای شفافسازی امور و مبارزه جدیتر با فسادهای دولتی است.

بررسیهای سازمان Transparency International نشان میدهد میزان بروز «فساد» در کشورها با سطح دسترسی به «کلاندادهها»، نسبت عکس دارد، یعنی در کشورهایی که دسترسی آزاد به دادههای عظیم وجود ندارد، میزان فساد بیشتر است؛ کشورهایی مثل زامبیا، میانمار و نپال در این گروه جای میگیرند. البته، صرف دسترسی آزاد به کلاندادهها، به معنی از بین رفتن فساد نیست.

در این حالت صرفا میتوان گفت شرایط و زیرساختها تا حدود زیادی برای کنترل فساد آماده است. برزیل، آرژانتین، مکزیک و اسلواکی از جمله کشورهایی هستند که با وجود امکان دسترسی آزاد به اطلاعات، میزان فساد در آنها بالاست. موضوعی که همه در خصوص آن اشتراک نظر داریم، تلاش برای کنترل فساد است؛ چراکه فساد، نه فقط باعث معضلات اقتصادی، بلکه حتی باعث به وجود آمدن مشکلات سیاسی و اجتماعی نیز میشود.

افزایش اختلافات طبقاتی، کاهش اعتماد عمومی مردم نسبت به یکدیگر و نیز نسبت به دولتها، افزایش میزان وقوع جرائم سازمانیافته و گسترش فقر در جامعه، تنها چند نمونه از «بیماری»هایی است که جامعه با آن دستوپنجه نرم خواهد کرد.

رباتهای هویداگر

در سال ۲۰۱۴ کارگروه مقابله با فساد گروه «G20»، دسترسی به دادههای باز (Open Data) را لازمه شفافیت و مقابله با فساد عنوان میکند. در سال ۲۰۱۵، در نشست ترکیه، این کارگروه، اصول و قواعد لازم برای دسترسی آزاد به اطلاعات را مشخص و طی بیانیهای آن را اعلام میکند تا کشورهای عضو، بتوانند آن را بهصورت دقیق اجرا کنند.

انتشار اطلاعات بهصورت دادههای باز، باعث شفافسازی فعالیت دولتها، مشخصشدن نحوه هزینهکرد بودجه عمومی و تسهیل شرایط همکاریهای بینالمللی میشود. پرواضح است که بررسی دادههای باز و کلاندادهها زمانبر است و شاید صحیحتر باشد بگوییم عملا غیرممکن است. با کمک هوش مصنوعی و یادگیری ماشین (Machine Learning)، در اینجا میتوانیم تعداد زیادی از دادهها را در زمان کوتاه بررسی و موارد مشکوکی را که با الگوریتمهای تعریفشدهمان مغایرت دارند، طبقهبندی و گزارش کنیم.

با انتشار دادههای باز در کشور برزیل، ربات هوشمندی به نام «Rosie» با بهرهگیری از یادگیری ماشین، توانست بیش از هشت هزار مورد مشکوک از تخلفات «نمایندگان» کنگره را کشف و گزارش کند. یکی از آنها نمایندهای در لاسوگاس بود که به رستوران Gordon Ramsay رفته بود.

در چین، اوضاع به گونه دیگری است. Zero Trust، ماشین هوشمندی که با هدف مبارزه با فساد، توسط آکادمی علوم چین طراحی شده، قادر است نقشه ارتباطات اجتماعی کارمندان / مدیران دولتی را بهصورت چندلایه طراحی و رفتارهای آنها را تجزیهوتحلیل کند. این ماشین همچنین قادر است با بررسی قراردادهای منعقدشده توسط هر کارمند / مدیر بر اساس سابقه رفتاری او، احتمال فساد در آینده و پروژههای مشابه را پیشبینی کند.

از سال ۲۰۱۲، Zero Trust توانسته هشت هزار و ۷۲۱ مورد تخلف انجامشده توسط دولتمردان (سوءاستفاده از قدرت، استفاده نابجا از بودجه دولتی و…) را گزارش کند. این موضوع باعث ایجاد حس ناامنی بین دولتمردان در شهرهای مختلف شده و همگی در تلاشند تا فعالیتهای این ماشین هوشمند را متوقف کنند.

وضعی که شاید از کنترل خارج شود

هاوکینگ میگوید: «ما انسانها زمانی که آتش را کشف کردیم، بارها خرابکاری کردیم تا توانستیم کپسول آتشنشانی را اختراع کنیم. ولی به نظر میرسد خرابکاری در حوزه هوش مصنوعی، خسارتهای جبرانناپذیری به همراه داشته باشد. در کنار تمام بحثها و موافقتها / مخالفتها با هوش مصنوعی و ماشینهای هوشمند، آنچه واضح است، این است که «باید اطمینان حاصل کنیم، رباتها و ماشینهای هوشمند قطعا در خدمت ما خواهند بود».

به عبارت دیگر، آنها باید موضوعاتی را بیاموزند که برای ما ارزش محسوب میشود تا همیشه و در هر حالتی، طرف ما باشند و هیچگاه برای نابودی ما برنامهریزی نکنند، اما آیا «ارزش»ها در فرهنگهای مختلف یکسان است؟ اطمینان یافتن از این موضوعات، کار دشواری است، چون ماشینی که «هوشمند» باشد، غیرقابل پیشبینی است.

به هیچوجه نباید فکر کنیم اوضاع تحت کنترل ماست؛ اگرچه هنوز در حال آزمون و خطا و بررسی جوانب مختلف موضوع هستیم، اما امروز به درجهای از علم رسیدهایم که میتوانیم «الگوریتم»هایی خلق کنیم که «یاد میگیرند»، مثل یک «نوزاد»، تجربه میکنند و یاد میگیرند، پس حتما باید مقررات دقیقی برای کنترل ساخت ماشینهای هوشمند و رباتها وضع کنیم.

«طمع» پیشرفت، گاهی باعث میشود این موضوعات را فراموش کنیم، آن وقت ممکن است اهداف الگوریتمهایمان، اهدافی نادرست و در «تضاد» با اهداف ما باشد و این موضوع به قیمت نابودی ما تمام شود.

در افسانههای یونان باستان آمده است: «در روزگاران دور، پادشاهی به نام «میداس» (Midas) حکمرانی میکرده و آرزو داشته هر چیزی را که لمس میکند، تبدیل به طلا شود. این آرزو لحظهای از ذهن او خارج نمیشده و به یکی از خواستههای اصلی زندگیاش تبدیل شده بوده است. روزی که این خواسته توسط «دیونیسوس» (Dionysus) برآورده میشود، میداس خوشحال میشود و سر از پا نمیشناسد.

ابتدا یک میز را لمس میکند و میز تبدیل به طلا میشود، سپس صندلی و فرش را لمس میکند و آنها هم تبدیل به طلا میشوند. وقتی هوس انگور میکند، به محض دستزدن، خوشه انگور تبدیل به طلا میشود، ناراحت میشود. همین حالت برای نان و آب و غذا هم تکرار میشود. احساس ترس وجود او را فرا میگیرد. دخترش که متوجه حال بد او میشود، نزدش میرود و او را در آغوش میکشد، اما وقتی میداس او را لمس میکند، او هم تبدیل به طلا میشود».